(Re)programmer des boîtes noires

Les hackers face à l’abstraction informatique et une omniprésente disparition du technique.

Élie Gavoty

Mémoire de recherche pour le Master LOPHISS 2015-2016 Université Paris Diderot

Dirigé par Mme Nadine de Courtenay, Soutenu le 6 septembre 2016.

Jury : Mme Nadine de Courtenay, Maître de conférence en histoire de la physique.

M. Sébastien Broca, Maître de conférence en science de l’information et de la communication.

Ce texte et ses schémas sont distribués sous licence Creative Commons BY-NC-ND

Illustration sous licence Creative Commons BY-SA auteur Elie Gavoty, d’après une icône de George Boukeas, basée sur le thème Gorilla Icon de Jakub Steiner.

version pdf

Résumé

Le hacker est une figure à la fois marginale et importante dans l’histoire de l’informatique. La culture hacker fait en effet converger, au sein de ce domaine, des approches techniciennes à la fois inventives et politiques autour de pratiques inhabituelles : le hacking implique une façon particulière de se rapporter aux systèmes informatiques entre création et détournement logiciel. Sans enfermer dans une caractérisation figée ces pratiques diverses et en évolution constante, l’objectif de ce mémoire est d’interroger la façon dont elles permettent de questionner une logique omniprésente de masquage de la technicité.

Notre approche débutera par un panorama de la culture hacker. Il s’agira dans un premier temps d’évoquer les origines de cette culture et certaines caractérisations classiques du hack, acte technicien esthétique et provoquant. Notre approche sera ensuite assez classiquement polarisée entre d’un côté le mouvement du logiciel libre et de l’autre le computer underground et les activités transgressives, souvent appelées cracking, qui s’y développent. Nous chercherons cependant à relativiser cette opposition en évoquant le processus, notamment politique, de sa construction.

Dans une deuxième partie, alimentée par des réflexions issues des STS de la philosophie de la technique et de philosophie de l’informatique, nous étudierons la notion de boîte noire. Cette notion, à la fois métaphore, modèle cybernétique et concept constructiviste nous permettra d’interroger une logique paradoxale du masquage du technique et en particulier des opérations appuyant le fonctionnement des artefacts. Nous proposerons ensuite une caractérisation en informatique de cette logique de la boîte à travers la notion centrale et structurante de l’abstraction.

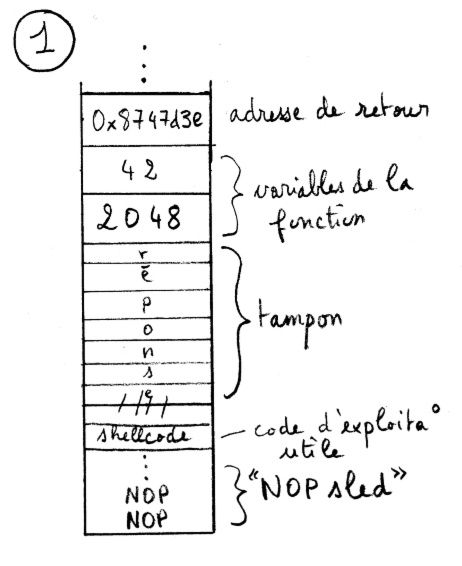

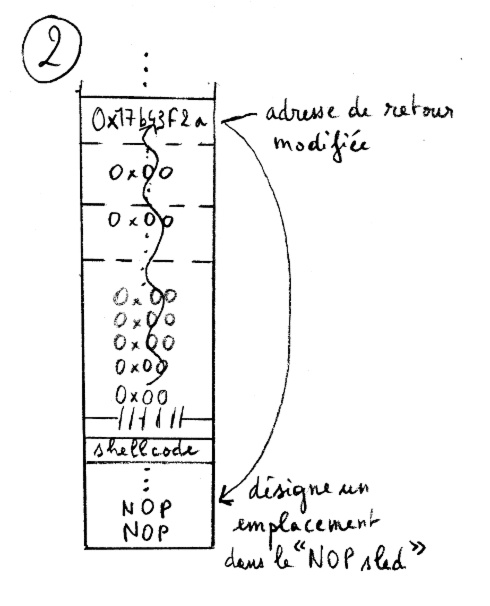

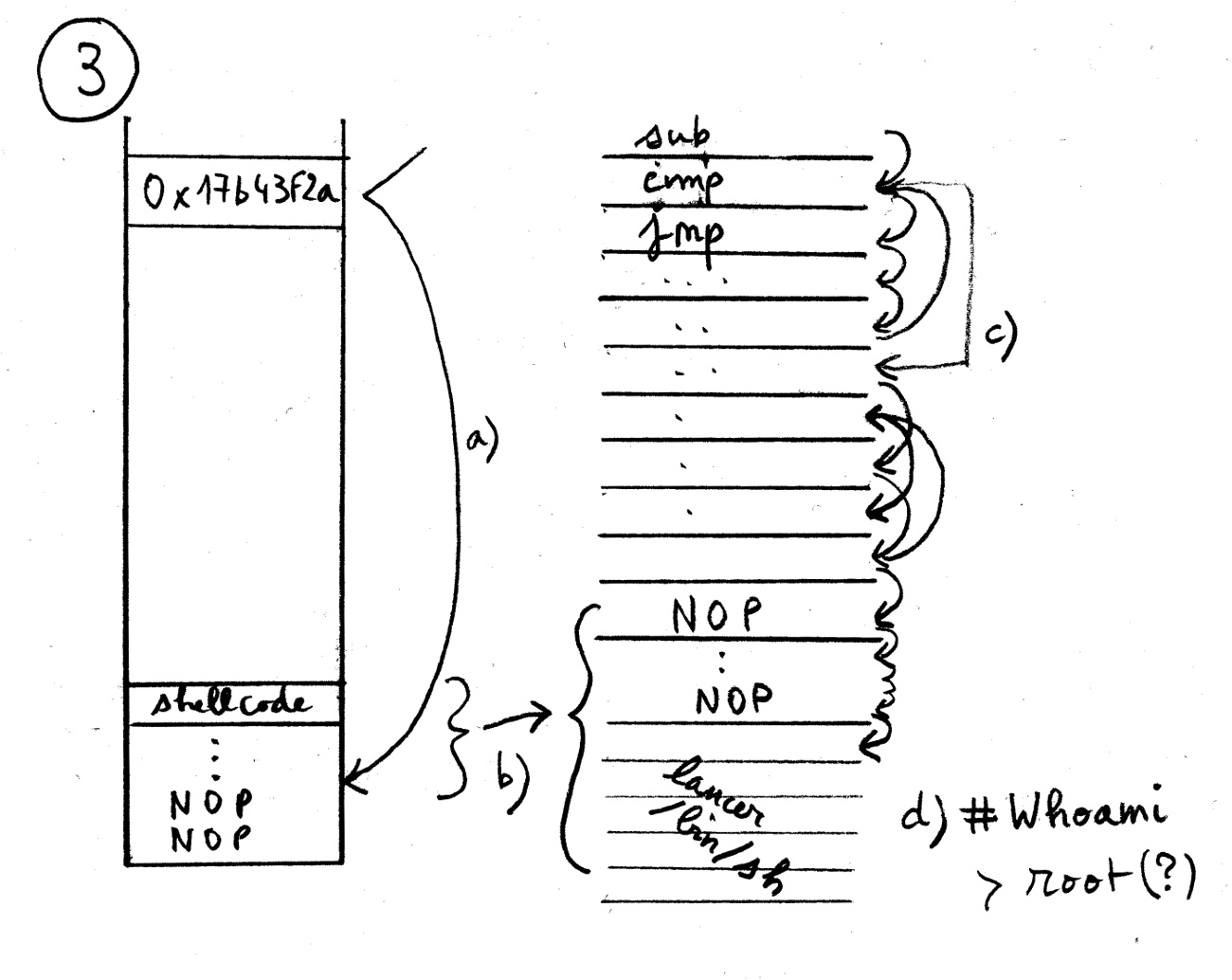

Dans ce cadre théorique décomposant les systèmes informatiques en différents niveaux de réalité, fonctionnant grâce à des boîtes noires multiples et emboîtées, nous chercherons à mettre en valeur une spécificité de l’action hacker. Pour cela nous étudierons en particulier un exemple de technique de hacking, l’injection mémoire par débordement de tampon. Ce type de masquage joue notamment un rôle important dans la séparation entre une position de concepteur et une position d’usager, qui est transgressée par les hackers. Ces derniers refusent en effet, en tant qu’utilisateurs des systèmes informatiques, de renoncer à un nouer un lien pratique avec la réalité opératoire de ces systèmes.

Enfin, nous aborderons la façon dont la notion de boîte noire qui décrit également la disparition du processus de genèse des systèmes techniques peut être vue comme le support d’une hégémonie de l’industrie informatique. Nous aborderons, cette notion d’hégémonie technique à travers l’exemple des l’interfaces graphiques et de la façon dont elle supprime la possibilité de programmer les ordinateurs. Cette approche ouvrira une direction théorique permettant de rendre compte de la dimension profondément politique des pratiques de hacking.

Mots clés : hack, logiciel libre, cracking, boîte noire, abstraction informatique, hégémonie technique, débordement de tampon,

Abstract

The hacker is an important although marginal figure in the history of computer technology. Hacker culture brings together in this technical domain political and creative approaches through unusual practices : hacking involve a particular relation to computer systems, between software creation and hijacking. Without minimizing the diversity and evolutive character of thoses practices, the aim of this work is to question how hacking reveals a pervasive tendency of technology to hide the operations and conditions of technical systems.

Our approach begins with an overview of hacker culture. It will first present the origins of this culture and certain classical descriptions of the hack, a technical, aesthetic and provocative act. The progression will then be classically divided between on one side the free software movement and on the other the computer underground and its transgressive activities, often called cracking. We will however discuss the construction process of this opposition, notably political, to overcome this apparent duality.

In a second part, based on STS, philosophy of technology and philosophy of computer science reflexions, we will study the notion of black box. This notion, as a metaphor, a cybernetic model and a constructivist concept, will help us to describe a paradoxal hiding of the technical conditions, in particular the operations which support technological artefacts functioning. We will then propose a caracterisation of this tendency in the context of computing through the central and structuring concept of computational abstraction.

In this theoretical framework, describing computers as layered systems, computing through multiple and nested black boxes, we will discuss the specificity of hacker action. Our analyse uses a particular hacking example : the memory injection through buffer overflow method. This kind of black box hiding supports a separation between the user’s and designer’s positions, which is transgressed by hackers. Those refuse in fact, as technically aware computer users, to drop out their practical link with the operational reality of computer systems.

Finally, we will consider that, as the black box notion also describe traditionally the disappearing of the social logic of technological systems, this hiding supports hegemonic strategies from the computer industry. We will discuss the notion of technological hegemony, which through the example of graphicals interfaces and the how they make it difficult and secondary to program computers. This approach will open a theorical direction to address the deeply political dimension of hacking practices.

Keywords : hack, free software, cracking, black box, computational abstraction, technological hegemony, buffer overflow

Remerciements

Tout d’abord, je suis ravi d’avoir eu l’occasion et la liberté de m’intéresser à de nombreux domaines très divers dans le cadre du master LOPHISS. À cette occasion j’ai pu rencontrer de nombreuses personnes passionnantes, étudiant.e.s et professeur.e.s que je remercie pour toutes les discussions enrichissantes que nous avons pu mener.

Mes remerciements vont également à tous ceux qui m’ont apporté une inspiration et un soutien indispensable durant la longue période d’élaboration de ce mémoire.

Je remercie Nadine de Courtenay, ma directrice de mémoire, pour sa confiance, ses encouragements qui ont su me faire croire dans ce projet qui me tenait à coeur.

Ce mémoire doit beaucoup à Maude qui m’a aidé de multiples façons et m’a donné le courage de continuer en des heures d’intense saturation ; à mes parents et mon frère qui m’ont soutenu et apporté leur aide dans le travail de rédaction ; à Aurélien pour son accueil à Bordeau et son intérêt ; à la famille Makhroff qui m’a accueilli chaleureusement à différentes étapes de ce travail ; à Odile, Karo et tous mes camarades de bibliothèque pour leur présence encourageante.

J’aimerais remercier également mes amis du Hackstub, qui poursuivent comme moi l’envie de transmettre une approche différente de l’informatique.

Introduction

Depuis quelques années, la culture hacker gagne en visibilité, en particulier en France. À travers le mouvement des hackerspaces1, ces espaces dédiés à la bidouille informatique qui apparaissent depuis peu dans diverses villes, une certaine forme de passion pour l’informatique trouve de nouveaux lieux d’expression et de diffusion. Parallèlement, un public de plus en nombreux fait un usage courant de logiciels libres, liés à la culture hacker, tels que le navigateur web Firefox, le système d'exploitation GNU/Linux ou encore les services libres en ligne proposés par l'association Framasoft. Cependant si différentes initiatives sortent du bois, l'ampleur de la « galaxie hacker » semble relativement méconnue et sa cohésion problématique. Comment les « exactions » des Anonymous, ce groupe médiatique d'activistes en ligne et les hackathons, événements ponctuels de développement logiciel, organisés notamment par Mozilla (entreprise derrière Firefox), sont-ils susceptibles d'être apparentés ? Cette cohésion de la culture hacker pose problème en terme d'identité pour les acteurs eux-mêmes : qui peut aujourd’hui se revendiquer hacker et pourquoi ? Les avis divergent.

La culture hacker est relativement ancienne. Elle trouve ses racines, durant les années 1960, dans deux mouvements techniciens assez spécifiques. D’une part, les concepts de hack et hacker proviennent d’un collectif étudiant du Massachussets Institute of Technology. D’autre part, une orientation plus transgressive, centrée sur les technologies de communication est héritière d'un mouvement de pirates téléphoniques appelés les phreakers(Sterling 1992). À la conjonction de ces deux tendances, au moment où les PC et les réseaux informatiques se répandent, notamment aux États-Unis et en Europe, s’est développé sous diverses formes un rapport à la fois pratique et politique à l'informatique comme technologie radicalement appropriable et partageable.

Au cœur de la culture hacker, on trouve traditionnellement un motif consacré : le hack désigne un acte technicien, qui en manifestant la compétence technique, l'astuce voire l'audace de son auteur l'élève véritablement au rang de hacker. La dynamique du hack lorsqu'on essaie de l'exprimer de façon générale, apparaît relativement abstraite (Jordan 2008, chap. 1). C'est qu'un hack peut s'appliquer à l'informatique dans de nombreux contextes, mais également à tout dispositif technique, voire pour certains, aux relations humaines. Là encore, ce qui constitue légitimement un hack est sujet à débat(E. G. Coleman 2013 Introduction) et la cohésion pratique du hacking demeure problématique.

Au-delà de ses origines historiques, on peut identifier en suivant notamment le sociologue Tim Jordan, deux orientations principales exprimant en pratique cette notion aujourd'hui. D'une part le cracking désigne généralement des pratiques très diverses de détournement ou de piratage qui visent à outrepasser ou à mettre simplement à l'épreuve la sécurité des systèmes informatiques. D'autre part la création de logiciels libres, c'est-à-dire de programmes informatiques dont le code est librement accessible, ce qui permet leur partage et un développement collaboratif. La mise en regard de ces deux orientations révèle une tension particulière entre, d'un côté, des pratiques de développement logiciel collaboratives, qu'on pourrait aisément qualifier de constructives et qui sont considérées très positivement de façon générale, et de l'autre des pratiques de détournement, transgressives voire délinquantes, c'est-à-dire dont la légitimité est largement contestée et qui sont perçues par beaucoup comme destructrices.

Lorsqu'on cherche à dépasser cette opposition, et que l'on considère les motivations qui guident les hackers dans leur diversité, on comprend que ce qui est au cœur du hacking est souvent le besoin de (re)prendre en main, de s'approprier librement les systèmes informatiques, en particulier de pouvoir les (re)programmer. Il semble notamment que les hackers ne trouvent pas leur compte face aux divisions professionnelles de l'informatique, séparant le travail de développement, c'est-à-dire une tâche de conception de l'usage d'un ordinateur tel qu'il est proposé aux utilisateurs finaux. Ils refusent en particulier une forme d'impuissance à laquelle sont assignés les usagers de l'informatique en tant que récepteurs de machines et de logiciels déjà parfaitement clos.

Cette situation renvoie plus conceptuellement à un paradoxe en philosophie de la technique : les différents aspects de la technicité (les opérations, décisions et réseaux) qui permettent le fonctionnement et la médiation opérée par les objets techniques (on parle plus largement d'artefacts techniques dont font partie les programmes informatiques) disparaissent généralement pour laisser la place à l'objet lui-même dans son identité fonctionnelle. Mais cette disparition participe d'une forme d'impuissance de l'usager à choisir et adapter les conditions de son environnement technique puisqu'elle le pousse à adopter une position de récepteur globalement passif. Même les logiciels libres, pourtant faits pour favoriser une forme d'appropriation plus profonde, semblent parfois pris dans ce paradoxe.

Dès lors, le hacking, lorsqu'il manifeste une volonté de transgression des conditions techniques existantes, nous paraît être un type d'activité philosophiquement intéressant en ce qu'il s'éloigne d'une logique de la boîte noire caractéristique de la technique moderne : plutôt que de réduire la technique, à une alternance de processus de conception et d'actes d'usage, il illustre une façon de remettre au centre de l'action les éléments du fonctionnement d'un artefact (généralement informatique) et une certaine réflexivité technicienne sur la médiation qu'il opère. Il s'agit ainsi de valoriser l'action transformatrice, voire contestataire, plutôt que la stabilisation des artefacts en tant qu'objets non problématiques.

Pour étudier cette originalité du hacking et du rapport hacker à l'informatique, nous chercherons ainsi à mettre en regard une approche transversale des pratiques de hacking inspirée par la littérature sociologique sur la culture hacker avec un questionnement plus conceptuel sur la notion de boîte noire. Cette dernière nous permettra en effet d'interroger sous différents angles la façon dont au coeur du technique se met en place un masquage de la technicité qui incorpore une forme de séparation entre conception et usage comme deux moments distincts. Il s'agira notamment de proposer un cadre théorique pour aborder la profondeur des systèmes informatiques et la centralité des processus de masquage dans leur architecture. Nous nous intéresserons dans ce contexte théorique à une technique de hacking particulière et en en quelque sorte canonique en sécurité informatique : l’injection mémoire par débordement de tampon. À partir de cet exemple, nous proposerons une analyse de l’attitude hacker en informatique comme un rapport particulier aux systèmes informatiques et à leur structure « feuilletée ». Enfin, nous aborderons, comment ces processus de masquage en informatique, en particulier dans le cas de la conception des interfaces graphiques, font écho à des logiques hégémoniques contre lesquelles luttent les hackers.

Les pratiques de hacking et leur dynamique culturelle.

Origine de la culture hacker et descriptions classiques du hack

Le hacking est une notion délicate à manipuler : elle fascine, car elle charrie à la fois une part de mystère en tant que forme d’engagement technique non conventionnel et parallèlement une part de transgression parfois valorisée, parfois minimisée par ceux qui se revendiquent hackers. Au-delà d’une image médiatique construite depuis les années 19802 qui assigne souvent le hacker au rôle du magicien informatique délinquant, la culture hacker manifeste une certaine diversité et une énergie techno-politique frappante3. Ainsi, il existe de multiples caractérisations conflictuelles du hacking comme activité et des qualités qui font le "véritable" hacker, aussi bien chez les acteurs qui se revendiquent de cette identité4 que dans la littérature. En effet, la culture hacker est ancienne et s'est largement diversifiée. Elle est traversée par des conflits générationnels5 et des divergences pratiques aussi bien que de culture politique. Enfin, elle est très stimulante et fait l'objet de nombreuses déclarations d'intention6. Ces tendances participent à un certain flou quant à l'emploi des termes hacker et hacking.

Nous nous proposons d'aborder dans un premier temps quelques approches classiques et de présenter rapidement une double origine historique de la culture hacker. Par la suite, pour donner une image plus actuelle des pratiques de hacking, nous évoquerons deux « genres »7 du hacking qui polarisent en quelque sorte la culture hacker aujourd'hui : il s'agit du « cracking » et du logiciel libre. Nous désignerons le plus souvent le « cracking » comme hacking transgressif ou détournement pour des raisons que nous développerons dans la partie I.2.3. Le logiciel libre met quant à lui en avant le hacking comme une pratique de programmation collaborative.

Ces précisions étant apportées, il semble utile, pour commencer, de s'intéresser à quelques définitions. Le qualificatif de hacker désigne souvent de façon assez générale un informaticien curieux et débrouillard8 ou plus précisément selon le Jargon File, un dictionnaire classique d'argot hacker :

A person who enjoys exploring the details of programmable systems and how to stretch their capabilities, as opposed to most users, who prefer to learn only the minimum necessary9.

Cependant, correspondre plus ou moins à cette définition ne suffit pas pour être considéré comme un hacker. En effet, cette culture est traversée par un certain élitisme et dans de nombreux cas une forme particulière de reconnaissance par les pairs est nécessaire pour faire de quelqu'un un hacker (Jordan 2008, chap. 2). Cette reconnaissance s'opère sur la base d'un type d'acte particulier, le hack qui manifeste l'ingéniosité, la maîtrise technique voire l'humour de son auteur. Le hack n’est pas aisé à cerner. En tant que « Graal »(Taylor 1999, 16) recherché par les hackers, il est réputé revêtir un sens subtil et profond qui défie l'explication10. De façon très générale, le hack est parfois caractérisé comme une « application adéquate de l'ingéniosité ». Il traduit la capacité d'agir de façon non orthodoxe et inventive dans des contextes technologiques et particulièrement informatiques.

Pour prendre un exemple élégant et humoristique de hack informatique, présenté par Gabriella Coleman, considérons un court programme écrit dans le langage de programmation Perl (E. G. Coleman 2013, 93) :

#count the number of stars in the sky $cnt = $sky =~ tr/*/*/;

L'objet de cette courte expression est comme l'indique le commentaire initial de « compter les étoiles dans le ciel ». En pratique, elle compte littéralement le nombre de caractères astérisque (*) d'un texte enregistré dans la variable « ciel » ($sky)11.

En plus du jeu de mots qui lui donne une connotation humoristique et poétique, cette expression célèbre la centralité de l'astérisque dans les systèmes UNIX12, et la puissance du langage Perl. En effet, elle démontre qu'il est possible d'effectuer, grâce à ce langage, un traitement informatique non élémentaire13 en seulement une ligne grâce à la syntaxe originale du langage qui laisse le programmeur condenser plusieurs opérations avec un minimum de symboles. Un programme explicite effectuant la même tâche utiliserait pour ce faire un code sensiblement plus long14. Le jeu qui consiste à condenser ainsi des expressions est très répandu dans la communauté des programmeurs Perl et demande une ingéniosité combinatoire certaine. Par cette simple expression, l'auteur manifeste une maîtrise importante des détails techniques du langage de programmation et de l'environnement informatique. Il élève en quelque sorte, par un acte qui n'est pas uniquement utilitaire, la programmation au rang de discipline poétique. Le hack et son rapport intime aux méandres de la programmation proviennent des pratiques développées par certains informaticiens du Massachussets Institute of Technology (MIT). Revenons sur cette origine de la culture hacker.

Naissance de la culture hacker au MIT et son éthique

Le sens original du terme hack se rapporte en anglais au fait de couper ou tailler grossièrement (Taylor 1999, 14). Il a été détourné, dans un premier temps, par quelques étudiants-ingénieurs appartenant au Tech Model Railroad Club (TRMC)(Levy 2013, chap. 1). Au sein de ce club, organisé* *autour d'une énorme maquette ferroviaire, les étudiants chargés de l'ingénierie électrique se prénommaient hacker avec une certaine fierté. Réparer et étendre cet immense système électrique en ajoutant de nouvelles routes, des dispositifs de contrôle, en testant et bricolant les systèmes à partir de matériel récupéré passionnait ces jeunes, souvent acclimatés à l'électronique depuis l'enfance. L'ensemble de ces pratiques impliquant beaucoup d'astuces et de capacité à résoudre des problèmes techniques avec peu de moyens constitue donc en quelque sorte un ancêtre du hacking en informatique. Les hackers donnaient une dimension héroïque et esthétique à cette activité technicienne. Steven Levy relate l'existence de poèmes vantant les exploits des hackers.

Les étudiants "hackers" du TRMC se tournèrent vers les ordinateurs en 1959, à l'occasion de l'ouverture d'un cours d'informatique débutant, proposé par John McCarthy, pionnier de l'intelligence artificielle. On peut relever une continuité frappante entre l'électronique et l'informatique de l'époque. Programmer une machine était un travail très fastidieux dans un contexte où la mémoire était très limitée et les opérations utilisées extrêmement élémentaires. Les machines tombaient également en panne et il fallait souvent intervenir directement au niveau électronique.

Les hackers développèrent progressivement, au sein du laboratoire d'intelligence artificielle (AI lab), une approche interactive de la programmation très originale à l'époque. Ils rejetaient le principe du traitement par lot, symbolisant une vision étriquée de l'ordinateur comme simple machine à calculs : dans cette approche, les tâches sont soumises les unes après les autres pour obtenir un résultat, concluant ou non. Le programmeur ne se confronte alors jamais directement à la machine. Au contraire, les hackers développèrent des programmes précurseurs, pour suivre l'exécution des calculs en temps réel et « déboguer » le programme au fur et à mesure. Ils conçurent également un des premiers systèmes d'exploitation à temps partagé qui permet à plusieurs usagers d'utiliser simultanément un ordinateur. Dans ce contexte, Levy relate divers types de hacks, ayant trait à l'optimisation des programmes ou encore à des usages innovants de l'ordinateur pour faire de la musique ou jouer (Levy 2013, chap. 2 et 3).

L’activité des hackers du AI lab répondait à un code informel. Il est formulé par Steven Levy, à partir d'entretiens avec les protagonistes, autour de six principes15. D'abord, l'accès aux machines et aux systèmes doit être libre, car l'exploration par le démontage et l'analyse est ce qui permet de vraiment comprendre les systèmes (nous appellerons cet impératif le principe d'accès direct aux machines). Deuxièmement, l'accès à l'information doit aussi être libre, notamment l'information technique qui facilite les hacks ultérieurs* (principe de divulgation* de l'information). Le troisième principe est la défiance de toute autorité et la valorisation de la décentralisation de l'accès à l'ordinateur* (principe anti-bureaucratique). Le quatrième principe concerne le refus qu'un hacker soit jugé sur autre chose que les compétences qu'il démontre en pratique et en particulier sur ses diplômes, son statut ou son âge (principe du mérite par le hack). Le cinquième principe souligne la valeur esthétique du hack informatique (principe esthétique). Enfin, le sixième principe affirme que l'informatique peut améliorer la vie ce qui n'a rien d'évident à l'époque (principe d'utilité générale*).

Ces principes font implicitement référence aux activités des hackers et dessinent en négatif les conditions matérielles et les obstacles, auxquels ils étaient confrontés dans leur pratique. En effet, comme nous l'avons évoqué, les hackers du MIT ont dû lutter pour avoir accès à des ordinateurs, rares et surveillés. Le principe direct d'accès aux machines traduit cette difficulté originelle à pratiquer l'informatique. Mais il ne s'agissait pas pour eux de se contenter d'une utilisation superficielle et indirecte de l'ordinateur, d'accéder en somme à du temps de calcul, mais bien de se confronter directement aux machines à leur interface matérielle (la console du TX-0) et leur fonctionnement interne. La culture hacker remet donc en cause, dès le départ, la constitution de l'ordinateur en une « boîte noire » masquant son fonctionnement pour exhiber un ensemble de fonctions « magiques ». Ce motif de la boîte noire, de l'abstraction masquant les détails techniques, est récurrent en informatique, mais également dans l'architecture de la plupart des techniques. Nous verrons dans la partie II qu'il traduit un aspect épistémologique central et ambigu de notre rapport à la technique. Les pratiques hackers sont, de ce point de vue, à contre-courant d’une attitude dominante face à l'environnement technologique, car elles valorisent l'attention au fonctionnement interne des systèmes.

Accéder aux entrailles d'un système n'est souvent pas suffisant pour le comprendre, le réparer, l'améliorer. Le principe que nous désignerons comme principe de divulgation affirme que l'information doit être libre, d'une part, pour faciliter voir simplement rendre possible l'étude des ordinateurs et des programmes16, mais surtout pour permettre l'utilisation du système. En effet, dès lors que les programmes informatiques, codés sous forme de suites de nombres, sont assimilés à de l'information, l'usage même de l'ordinateur implique de pouvoir accéder à ces outils informationnels. De plus, au-delà de ces considérations pratiques, les hackers du MIT ont perçu très tôt, une certaine universalité de l'ordinateur traitant l'information numérique et perçoivent le monde à travers ce prisme informatique. De ce point de vue, un libre flux d'information est ce qui permet d'améliorer le fonctionnement d'un ordinateur et donc également du monde, perçu comme informationnel17. Ce principe doit, dès lors, être formulé de façon générale et appliqué le plus largement possible. Il en résulte des parallèles amusants :

« To a hacker, a closed door is an insult, and a locked door is an outrage. Just as information should be clearly and elegantly transported within a computer, and just as software should be freely disseminated, hackers believed people should be allowed access to files or tools which might promote the hacker quest to find out and improve the way the world works. » 18

Le troisième principe est lié à une critique de la bureaucratie (principe anti-bureaucratique). Les hackers abhorrent les systèmes centralisés et hiérarchisés, parce qu'ils forment des obstacles à l'accès aux ressources et à la circulation des informations. Ils instituent des règlementations arbitraires entravant la curiosité hacker. Ils sont plus fondamentalement incapables de tolérer les pratiques exploratoires qui forment le coeur du hacking. En effet, ces dernières cherchent toujours à aller au-delà des règles : les hackers du MIT recherchent une liberté radicale dans la programmation qui s'accommode mal des limitations légales. De ce point de vue, IBM, entreprise très largement dominante et hiérarchisée, produisant des ordinateurs énormes et chers constitue la figure repoussoir contre laquelle se définissent les hackers dans leur activité19.

Le principe suivant se présente comme une forme de méritocratie particulière, dans laquelle la source légitime d'autorité est l'investissement dans le hacking et la capacité à produire des hacks remarquables. Les hackers valorisent ainsi les exploits gratuits et un savoir-faire plutôt que les statuts sociaux. Pour ces passionnés, peu sociables, l'idée de devoir justifier leur pratique par des diplômes ou une origine sociale pour pouvoir pratiquer l'informatique est profondément absurde. Ils ont par exemple accueilli un passionné adolescent, dans ce milieu universitaire, qui a été reconnu pour son investissement personnel et ses capacités en programmation. Ce principe central parmi les hackers du MIT semble trouver une continuation au sein des générations suivantes, en particulier dans l'idée de « do-ocracy »20 structurant aujourd'hui le développement communautaire de logiciels libres. Nous aurons l'occasion d’y revenir.

On pourrait considérer le hack musical de Peter Samson comme un bon exemple d'une démarche artistique associée à l'ordinateur : il utilisa un petit son de diagnostic, de hauteur variable, pour jouer un morceau de musique en écrivant un programme informatique. Mais il serait pourtant erroné d'associer le principe esthétique hacker aux créations artistiques produites grâce à un ordinateur, selon des critères culturellement indépendants de l'informatique (la beauté des morceaux de musique numérique dans le paysage global de la création musicale par exemple). La valeur esthétique dont il est question ici concerne bien plus profondément les activités de la programmation et du hacking sur leur versant d'abord informatique et technologique21. Ainsi pour les hackers, le code d'un programme possède une qualité esthétique propre, liée en particulier aux astuces sur lesquelles il s'appuie, à sa taille réduite au minimum, à la maîtrise algorithmique et la connaissance de la machine qu'il manifeste. Dans le contexte technique dans lequel opère les premiers hackers, c'est-à-dire avec un ordinateur comme le TX-0, peu performant et disposant de très peu de mémoire pour stocker les programmes, le fait de pouvoir écrire un programme avec le moins possible d'instructions est très intéressant : disposer d'un programme court permet de charger plus de programmes en même temps et une exécution plus rapide. Hacker consistait alors par exemple à mettre toute son astuce au service de l'économie d'instructions du programme.

Ce critère n'est plus valable de la même façon aujourd'hui, alors que la mémoire disponible sur les ordinateurs est très importante, largement suffisante pour charger tout code nécessaire. On peut cependant retrouver des critères de valorisation de la concision du code, notamment dans le conflit entre les hackers amateurs du langage Python et ceux préférant le langage Perl. Alors que le premier est volontairement très explicite et formaté pour favoriser la lisibilité, le second permet des raccourcis et comportements implicites qui rendent possible de puissantes expressions extrêmement concises. Cependant, il est alors difficile de comprendre le déroulement algorithmique, ce qui rend le code en Perl moins adapté à un environnement collaboratif. On peut dire que le langage Perl est plus adapté à l'exploit individuel du programmeur et aux expérimentations esthétiques sur le code alors que le langage Python a été créé pour favoriser le partage et la transparence. Plus généralement, cette valorisation collective d'une esthétique du hack et en particulier du code informatique, manifeste une mise en culture d'activités techniques traditionnellement très professionnalisées et utilitaires. La valorisation esthétique s'hybride alors avec des considérations, notamment fonctionnelles, que l'on fait habituellement appartenir à un tout autre ordre de valeur.

Enfin, le dernier principe affirme que l'ordinateur peut améliorer la vie humaine. L'informatique est aujourd'hui ubiquitaire, au point que nous ne sommes plus que très partiellement conscients au quotidien du rôle des ordinateurs et des diverses fonctions qu'ils remplissent pour nous faciliter la vie. Dans les années 60, au contraire, les ordinateurs étaient présents principalement aux États-Unis et considérés comme des machines très spécialisées, utiles dans quelques branches professionnelles, pour le calcul scientifique en particulier. Sans imposer aux autres comme une évidence cette intuition d'une utilité très large de l'ordinateur, à une époque où les ordinateurs étaient de fait inaccessibles pour l'immense majorité des gens, les hackers ont vu leurs vies effectivement transformées par les premiers ordinateurs. Cette confiance dans l'intérêt de ces machines et dans l'utilité générale des solutions informatiques a amené les hackers de la génération suivante à défendre la démocratisation de l'ordinateur.

Hack et Phreaking

Le hacking ne concerne pas nécessairement l'informatique. Il peut s'appliquer à de nombreux systèmes technologiques, voir par analogies à de nombreuses situations pratiques(Taylor 1999, 17). En outre, il manifeste souvent une dimension transgressive, voire illégale, centrale dans la culture hacker. Sherry Turkle, dans une tentative classique pour illustrer les caractéristiques s'intéresse à un autre type de pratique, le phreaking. Il s'agit d'une forme de piratage téléphonique, qui consiste pour ses pratiquants à débloquer certaines fonctions de contrôle du réseau, par divers procédés, en particulier grâce à l'utilisation des « phreaking boxes »22 . Le hack étudié par Turkle, initié par un phreaker célèbre nommé Captain Crunch, consistait à l'aide d'une paire de téléphones et d'une « blue box » à déclencher une série d'appels internationaux en piratant le réseau. Ensuite lorsqu’il parlait dans l'un des combinés, on entendait sa voix dans le second avec un délai important indiquant que l'appel venait d'effectuer le tour du monde.

« Appreciating what made the call around the world a great hack is an exercise in hacker aesthetics. It has the quality of [a] magician’s gesture: a truly surprising result produced with ridiculously simple means. Equally important: Crunch had not simply stumbled on a curiosity. The trick worked because Crunch had acquired an impressive amount of expertise about the telephone system. That is what made the trick a great hack, otherwise it would have been a very minor one. Mastery is of the essence everywhere within hacker culture. Third, the expertise was acquired unofficially and at the expense of a big system. The hacker is a person outside the system who is never excluded by its rules. »23

Ainsi selon Turkle, le hack est un acte de détournement qui combine la simplicité, une maîtrise manifeste d'un système technique complexe, et une dimension de transgression des règles imposées par « le système ». Plus largement, comme le présente Gabriella Coleman, la communauté phreaker et sa proximité avec le mouvement politique des Yippies dans les années 70 constitue l'une des origines des positions politiques de critique radicale du système, caractéristiques du computer underground hacker jusqu'à aujourd'hui (G. Coleman 2012).

Les travaux désormais classiques de Steven Levy et Sherry Turkle datent de 1984 et l'informatique a beaucoup évolué depuis avec notamment l'apparition de l'ordinateur personnel et d'Internet. Les hackers ont d'ailleurs joué un rôle important dans ces innovations24. Il s’agit dès lors de s’intéresser aux formes plus contemporaines de cette culture. Pour cela, Tim Jordan propose de comprendre la dynamique du hacking au niveau pratique en mettant en regard les pratiques de développement collaboratif portées par le mouvement logiciel libre et les pratiques transgressives du computer underground. Bien que cette catégorisation classique soit contestable(G. Coleman et Golub 2008 Introduction), elle nous semble correspondre à une perception répandue de l’héritage hacker. Nous la reprendrons donc dans le but notamment de la questionner.

Logiciel libre : mettre en partage les logiciels et défendre leur appropriation technicienne

Le logiciel libre (ou Logiciel Libre et Open Source souvent abrégé F/OSS)25 fait avant tout référence à un ensemble de pratiques de création collaborative de logiciels informatiques dont le code est rendu librement accessible à travers Internet et modifiable à volonté. Cependant, le logiciel libre se retrouve également au centre d'un vaste public qui par ses pratiques et son rapport particulier aux infrastructures informatiques participe de façon centrale à la construction d'Internet et de l'informatique actuelle. Cette forme spécifique de collectif, que Christopher Kelty(Kelty 2008) caractérise en introduisant la notion de « public récursif » sera l'objet de la partie 2.2. Enfin, nous nous interrogerons sur ce qui relie en pratique le développement logiciel à la notion de hack précédemment évoquée et notamment à sa dimension transgressive.

Définition et premières implications informatiques du logiciel libre

Tel qu'on le rencontre en tant qu'usager d'un ordinateur, un logiciel libre est avant tout un logiciel26 librement téléchargeable et utilisable, mais également dont le code source27 est publiquement accessible. Ces logiciels sont souvent gérés de façon communautaire : ils sont développés par des contributions de programmeurs d'horizons différents et distribués sous diverses formes à l'usage de tout un chacun. Mais le logiciel libre est également un mouvement d'un type particulier organisé autour de ces pratiques de développement informatique collaboratif pour défendre leur spécificité, c'est-à-dire une façon d'envisager les programmes informatiques comme des biens communs appropriables.

La notion de logiciel libre (free software) et le mouvement éponyme remontent à 1983. Elle fut introduite par un hacker de l'AI Lab du Massachusetts Institute of Technology, Richard Stallman. Elle découle directement de l'éthique de travail collectif des hackers et des pratiques universitaires de partage du code informatique. Cependant à l'époque, une transformation rapide du monde du logiciel en un écosystème commercial fermé et protégé par des brevets menaçait ce rapport libre à l'informatique. Stallman décida alors de lancer un projet, nommé GNU28, et introduisit pour le caractériser la notion de logiciel libre29, afin d'une part de réaffirmer l'importance en informatique d'accéder au code des logiciels et d'autre part de rassembler les hackers encore susceptibles de défendre cet idéal. Il s'agissait concrètement de développer un système d'exploitation dont le code serait à jamais un objet collectif, librement disponible et modifiable.

Selon cette approche de Stallman, devenue en quelque sorte canonique, un logiciel est dit libre s’il respecte quatre libertés :

- « la liberté d’exécuter le programme comme vous voulez, pour n’importe quel usage (liberté 0);

- la liberté d’étudier le fonctionnement du programme, et de le modifier pour qu’il effectue vos tâches informatiques comme vous le souhaitez (liberté 1) ; l’accès au code source est une condition nécessaire ;

- la liberté de redistribuer des copies, donc d’aider votre voisin (liberté 2) ;

- la liberté de distribuer aux autres des copies de vos versions modifiées (liberté 3) ; en faisant cela, vous donnez à toute la communauté une possibilité de profiter de vos changements ; l’accès au code source est une condition nécessaire. » 30

En 1985, au moment de la distribution du premier logiciel GNU, Stallman écrivit une toute première version de la General Public Licence (GPL), pour qualifier juridiquement les libertés associées au logiciel libre. En effet, si le partage de code, librement disponible et modifiable, était une pratique courante dans le milieu universitaire des années 60 et 70, le cadre juridique habituel du domaine public, n'était pas satisfaisant. Stallman désirait protéger les logiciels libres d'une réappropriation et d'une intégration de leur code dans des logiciels non libres. Il introduisit pour ce faire une clause qui contraint tout développeur utilisant le code d'un logiciel libre sous licence GPL à distribuer son logiciel selon cette même licence, c'est-à-dire en respectant les libertés associées. Ce hack juridique31 fonde ce que l'on appelle le copyleft, c'est-à-dire un retournement du copyright anglo-saxon de façon à protéger non pas une possession exclusive du code, mais une possession collective de celui-ci. Cette première licence libre, encore largement utilisée aujourd'hui dans sa version mise à jour32. De plus, le copyleft s'applique désormais à d'autres objets, par exemple des livres, des images et des œuvres d'art.

Pour clarifier, le cadre informatique qui donne son sens en pratique aux libertés du logiciel libre, il est utile de comparer son code « ouvert » avec son pendant au code « fermé » qu’on désigne habituellement du qualificatif de propriétaire. Les logiciels sont initialement écrits sous la forme d'un code qu'on qualifie de * source. Un tel code est formulé dans un langage potentiellement compréhensible par l'humain, car composé de mots organisés selon une syntaxe régulière. Cependant, sous cette forme le programme n'est pas lisible par le(s) processeur(s) de la machine. Il doit être, à un moment ou un autre traduit en langage machine. Le programme peut alors être compris par l'ordinateur, c'est-à-dire lancé et utilisé, mais non par l'humain. En effet, le code machine* exécutable se présente sous la forme d'un imbroglio binaire (codé sous forme de 0 et de 1). Les opérations sont alors difficilement distinguables et si élémentaires que la logique du programme est extrêmement fastidieuse, voire impossible à reconstituer33. Le processus de traduction d'un code source en un binaire exécutable, appelé compilation, est fondamental en informatique.

Généralement, un logiciel propriétaire (ou encore* privatif)* est techniquement un programme pour lequel le code source n'est pas distribué par ses créateurs. Seul un programme sous forme compilé c'est-à-dire un fichier exécutable est disponible. Le programme se présente alors en pratique comme une boîte noire34 dont seuls les créateurs connaissent la logique de fonctionnement. Au contraire, l'ouverture du code en tant que caractéristique technique a de nombreuses conséquences pratiques et autour d'elle cristallise également la dimension politique portée par le mouvement. En effet, avoir accès au code source du programme correspond, dans les conditions techniques particulières de l'informatique à disposer à la fois d'un artefact technique35 en tant que tel36 et d'une description de sa logique/structure qui constitue une connaissance technique souvent suffisante pour comprendre cette dernière à peu près intégralement. Il est possible, lorsque le code source est disponible de s'approprier, dans la mesure de son temps et de ses compétences, un logiciel d'une façon tout à fait différente d'un usager habituel : chacun peut se faire en quelque sorte (re)concepteur du programme pour changer plus ou moins profondément ses fonctions, améliorer sa conception, supprimer certaines parties jugées inadéquates ou dangereuses37. Pouvoir lire et comprendre le code d'un programme est également la seule façon de s'assurer que ce dernier fait bien ce qu'on pense qu'il fait. En effet, au-delà de l'évidence de ce qui se déroule sur l'écran, les traitements informatiques sont largement invisibles38 et il est très aisé de cacher des dispositifs malveillants39. Comprendre, contrôler et s’approprier au niveau technique ce que fait le programme constitue pour Stallman, et pour une grande partie des hackers dont il s'est fait le porte-parole, une liberté fondamentale de tout usager d'un ordinateur. Cette liberté d'appropriation ne s'impose d'ailleurs pas plus aujourd'hui qu'à l'époque comme un droit des usagers dans nos sociétés dites technologiquement avancées : des smartphones aux consoles de jeu vidéo en passant par les multiples services qui fleurissent sur Internet à l'heure du nuage, la majorité des industriels redoublent ces dernières années d'efforts pour s'octroyer un contrôle en aval sur tous leurs produits et services au détriment des possibilités d'appropriation par les usagers40. Pour Stallman, face à cette tendance, le logiciel libre constitue un mouvement social œuvrant pour défendre la liberté des utilisateurs, notamment à choisir ce qui constitue pour eux une technologie utile et éthique.

Cependant, cette approche politique du logiciel libre comme un mouvement social ne fait pas l'unanimité41 : face aux premiers succès commerciaux du logiciel libre, apparaît en 1998 la notion d'open source défendue notamment par le libertarien Eric Raymond. Cette nouvelle qualification, outre qu'elle règle le problème de l’ambiguïté du mot free en anglais42, fut portée stratégiquement à la fois pour prendre le contre-pied de l'approche engagée de Stallman que Raymond et de nombreux hackers considèrent comme idéologique (Broca 2013, 62‑63, 69‑70), mais également pour changer l'image et les conditions de distribution du logiciel libre et ainsi le rendre plus compatible avec l'industrie. Cette transformation des logiciels libres en un phénomène relativement soluble dans l'industrie logicielle s'est effectivement opérée et les logiciels libres et open source se sont diffusés largement dans divers pans de l'informatique43.

Une certaine forme de rupture s'est confirmée par la suite entre les deux approches, Stallman évitant par exemple de fréquenter les événements étiquetés open source. Il les décrit comme deux factions opposées au sein d'une même communauté, l'une assumant et exprimant la dimension politique de son engagement et l'autre insistant sur la dimension techniquement et économiquement avantageuse de l'ouverture. Pourtant, il affirme également que cette opposition n'empêche pas une certaine cohésion de la communauté, les divergences politiques n'entravant pas la coopération pratique autour d'objectifs communs.

En fait selon Christopher Kelty, le phénomène du logiciel libre excède ce qu'on appelle traditionnellement un mouvement(Kelty 2008, 98). Pour lui, la dimension de mouvement n'est qu'une composante de ce qui fait du logiciel libre et open source un phénomène original et la matrice d'une tendance plus vaste44. Cette composante de mouvement est liée avant tout à la réflexivité de la communauté, aux disputes et clarifications quant aux enjeux pratiques et politiques de l'ouverture et du partage des logiciels. Ainsi plutôt que de se former d'abord autour d'une cohésion symbolique et politique ce collectif fonctionne justement, car autour des logiciels libres et d'Internet qui permettent un partage d’artefact et de culture techniques se construit un contexte dans lequel il est possible de travailler ensemble. Pour parler de cette forme collective, dont il décèle une forme possible de généralisation, Christopher Kelty introduit la notion de public récursif.

Le collectif du logiciel libre : constitution d'un public récursif.

Pour saisir la forme particulière du public récursif du logiciel libre, il s'agit selon Kelty de s'intéresser à une « concentration particulière de pratiques »(Kelty, préface de Broca 20132013, p.10). Il la décompose en cinq composantes qui se développent à différentes époques et convergent pour donner au public du logiciel libre sa dynamique particulière.

La première composante dans cette analyse est celle du logiciel libre et open source en tant que mouvement, c'est-à-dire la prise de conscience de l'existence d'une communauté large valorisant l'ouverture et le partage du code ainsi que les discussions quant à son identité et ses enjeux.

La deuxième composante qui constitue le cœur pratique du logiciel libre est le partage du code source informatique ; comme nous l'avons évoqué, ce partage implique que le code soit facilement disponible et modifiable et permet d'envisager une forme de travail de conception technique à plusieurs mains. Les pratiques de partage de code trouvent leurs racines dès les années 70, avec la révolution constituée par le système d'exploitation UNIX : il s'agit du premier système d'exploitation véritablement indépendant du matériel, c'est-à-dire que le même code était capable de fonctionner sur de nombreuses machines grâce au processus de compilation. Entre autres qualités, cette possibilité d'adapter UNIX à différents contextes informatiques et le fait que le code était distribué avec le logiciel ont garanti sa popularité parmi les informaticiens : distribués librement et améliorés par des professionnels pour leur propre usage, les programmes compatibles et versions du système se sont multipliés jusqu'à créer un écosystème énorme devenu de facto un standard45. L'histoire d'UNIX a en quelque sorte rendu naturelle l'idée du « fork » centrale dans le logiciel libre : dès lors que le code est partagé, il est possible de créer sa propre version d'un logiciel existant en aménageant son code ou en le réécrivant presque totalement, pour l'utiliser ou par exemple pour des raisons d'apprentissage.

Mais le fait de disposer d'un accès au code ne fait pas nécessairement des systèmes informatiques des écosystèmes ouverts et compatibles. Pour pouvoir communiquer informatiquement, il est nécessaire notamment d'élaborer un protocole qui sera respecté par les différents systèmes et logiciels. Le troisième jalon mis en valeur par Kelty est le tournant des réseaux informatiques dans les années 80. Il devint alors largement évident que l'avenir de l'informatique se situait dans le partage d'information plutôt que simplement dans le calcul. Pour cette raison, l'industrie informatique commença à valoriser l'interopérabilité, en particulier des systèmes Unix, autour du concept d'Open System. En outre, les premiers protocoles réseau standard et génériques virent le jour, en particulier la norme TCP/IP à la base d'Internet. Cependant dans un contexte de concurrence où les différents industriels voulaient imposer leur version et abusaient pour cela des brevets logiciels, cette promotion de l'ouverture se solda en pratique par un échec. La « guerre » des versions d'Unix se conclut sur la victoire d'écosystèmes incompatibles et radicalement fermés : les systèmes Msdos, puis Windows, vendus* par Microsoft.*

La quatrième composante apparaît dès lors comme une solution à cet échec des Open Systems. Il s'agit, à travers la création de diverses licences libres, de la formation de cadres juridiques permettant, comme nous l'avons évoqué précédemment de défendre une forme de mise en commun des logiciels et des protocoles. Ainsi, en plus de sa composante technique, la composante juridique est centrale pour le logiciel libre et l'établissement de cadres dans lesquels contester les modes traditionnels de la propriété intellectuelle. En outre, une forme de comparaison entre technique et juridique, présente en particulier dans les travaux du juriste Lawrence Lessig46, nous semble relativement influente dans la culture hacker : en tant qu'il fait exister le cyberespace d'une façon particulière, le code informatique, définit et contraint les comportements collectifs, d'une façon semblable aux lois, si ce n'est que cette législation technique est plus fondamentale, car elle précède et conditionne les processus législatifs traditionnels.

Enfin, la cinquième composante est la constitution de modes nouveaux d'organisation et de gouvernement du travail collectif de développement, tirant notamment parti d'Internet. Un exemple classique en la matière est l'organisation du développement du noyau47 Linux, initié par Linus Torvald et qui a dès l'origine impliqué des dizaines de développeurs. Eric Raymond caractérise cette organisation, par la métaphore du bazar : plutôt que de partir avec un objectif logiciel ambitieux et précisément conçu, Linux Torvald travailla, partant d'un projet minimal de noyau déjà existant et fonctionnel, à son amélioration pour atteindre un objectif pragmatique : le faire fonctionner sur un ordinateur personnel IBM PC. Lorsqu'il mit à disposition son code sur le net, de nombreux développeurs, intéressés par l'existence d'un noyau libre fonctionnel pour PC, aussi modeste soit-il, contribuèrent au projet. Torvalds se laissa guider par les contributions et les besoins de ses usagers en intégrant toutes les modifications intéressantes apportées par d'autres au logiciel. Ce mode de développement, très étonnant au regard des modes d'organisation de projets logiciels de l'époque, s'avéra très fructueux puisque le noyau en vint en quelques années à concurrencer les solutions commerciales. C'est en grande partie l'exemple de Linux qui fut au centre des discussions sur l'open source comme modèle de développement, au point qu'il fut discuté bien au-delà des cercles libristes jusqu'à influencer la pensée managériale. Mais, partant de ces innovations des années 1990, chaque projet libre présente une forme d'organisation collaborative relativement spécifique, plus ou moins doocratique, plus ou moins formelle, exploitant différents outils pour aider à l'intégration du code et la gestion collective des versions48.

À travers ces différents jalons, on comprend que le logiciel libre est un phénomène à de nombreux égards paradigmatique. Concrètement, les logiciels à sources ouvertes sont aujourd’hui au cœur de l’informatique : on peut traditionnellement relever que le navigateur Firefox, les systèmes d’exploitation de la famille GNU/Linux, très utilisés notamment sur les serveurs à la base d’Internet, ou encore des composants logiciels cruciaux comme le logiciel serveur HTTP Apache, sont libres. Plus largement, cette orientation collaborative du développement logiciel a débouché sur un modèle reconnu et largement mis en valeur jusque chez les ténors de l’industrie du logiciel. On pourrait, pour illustrer cette dimension paradigmatique du libre, s’intéresser au phénomène récent qui se constitue autour de la plateforme Github : ce réseau social basé sur le développement contributif et le code source comme vecteur d’interaction sociale, rencontre un franc succès chez nombre de développeurs professionnels ou amateurs, au point de transformer les habitudes dans le champ de l’informatique.

D’autre part, la spécificité de ce phénomène collectif est liée à sa dimension récursive :

« Why recursive? I call such publics recursive for two reasons: first, in order to signal that this kind of public includes the activities of making, maintaining, and modifying software and networks, as well as the more conventional discourse that is thereby enabled; and second, in order to suggest the recursive « depth » of the public, the series of technical and legal layers—from applications to protocols to the physical infrastructures of waves and wires—that are the subject of this making, maintaining, and modifying. The first of these characteristics is evident in the fact that geeks use technology as a kind of argument, for a specific kind of order: they argue about technology, but they also argue through it. »49

La récursivité, concept fondamental en informatique, décrit ici le public des geeks en tant qu’il s’est constitué par et pour l’informatique et Internet. Tels des homo faber numériques, ils produisent un monde technique partagé, des infrastructures logicielles et réseau qui sont à la fois l’objet et le milieu de leur mobilisation collective. Cela implique une articulation permanente du technique et du politique, du pratique et du symbolique.

Nous avons introduit le logiciel libre comme une composante centrale de la culture hacker. Dans quelle mesure, ce public récursif des geeks, mobilisés par le phénomène du libre et de l’open source correspond-il plus généralement à celui des hackers dont nous interrogeons les spécificités ?

Kelty désigne bien par le terme de geek, les héritiers de la culture hacker dans un sens inclusif. Au sens strict, il s’avère qu’il y a des hackers qui ne participent pas au développement du libre et des libristes qui sont gênés par la figure du hacker, voire des partisans des sources ouvertes au sein d’entreprises dont l’idéal est bien éloigné de l’éthique hacker. Cette question d’identité est donc complexe et instable (Söderberg 2011, 22). Kelty utilise justement la figure du geek comme une identité plus générale et détachée des forts enjeux d’appartenance et des disputes qui sont associées à la figure du hacker. Ces enjeux sont marqués en particulier par l’élitisme revendiqué de certains hackers et d’autre part par l’image de déviance associée à cette figure50. En outre, comme nous l’avons évoqué, il y a une forte dispersion de la notion de hacking et donc également des identités associées. Au contraire, Johan Söderberg critique le choix de ce terme de geek (Söderberg 2011, 28) : l’identité de hacker lui semble en effet d’une part généralement revendiquée par les acteurs et d’autre part plus à même de faire référence à leur ambition de maîtrise technicienne, héritée des premiers hackers américains.

Cependant, au-delà, de distinctions principalement terminologiques, la notion de public récursif, en proposant d’aborder cette question au niveau des pratiques, des infrastructures techniques et de l’autonomie collective qu’elles produisent s’adapte bien à une compréhension des collectifs hackers, qu’ils appartiennent ou non à ce que Coleman et Golub appellent le « genre moral » du libre. Pour poursuivre cette interrogation du rapport entre logiciel libre et la culture hacker il nous semble dès lors pertinent de nous intéresser à la convergence pratique entre le libre et les orientations plus transgressives de la culture hacker. Ainsi on peut se demander en quoi les activités de développement logiciel qui sont au centre du libre peuvent-elles se rapporter au motif du hack que nous avons évoqué dans la première partie. Ou dit autrement, en quoi l’approche de création de programmes informatiques au sein du mouvement du logiciel libre est-elle voisine d’autres pratiques de hacking, notamment celles qui consistent à détourner ou pénétrer des systèmes informatiques ?

Le développement de logiciel libre comme activité de hacking.

L’activité de production logicielle prend typiquement dans le cadre des projets de logiciel libre, une forme itérative : le programme se développe par des contributions ponctuelles qui lui ajoutent de nouvelles fonctionnalités ou corrigent des erreurs et bogues. Le programme passe ainsi d’un état fonctionnel à un autre légèrement plus étendu ou fiable. Dans cette approche, le développement n’est pas nécessairement planifié. Elle s’oppose ainsi, comme le relève notamment Gisle Hannemyr51, à une approche d’ingénierie logicielle52, dans laquelle tous les développements doivent préalablement être décrits sous forme de spécifications et où le développement est dirigé hiérarchiquement.

Dans le cadre d’une approche industrielle du développement, il s’agit ainsi de produire des composants logiciels partiels pour répondre à une liste de spécifications préétablies et de scinder les tâches de développement pour les répartir sur une équipe avec des spécialités. Dans le cas du producteur de logiciel, de la même façon que dans le cas d’un ouvrier qui produirait des pièces métalliques sans être véritablement impliqué dans la création de la machine résultante, cela a pour résultat que le producteur est peu concerné personnellement par les qualités potentiellement complexes et non univoques de l’objet résultant. Il ne réalise notamment pas le logiciel, car ce dernier fait sens d’un point de pratique pour lui, mais seulement pour répondre à un cahier des charges largement extrinsèque. Hannemyr qualifie en comparaison l’approche hacker d’artisanale : il s’agit pour un hacker de produire des programmes sur des bases volontaires et autonomes en définissant, souvent pour son propre usage, ce qui constitue la forme et les qualités adéquates de l’artefact informatique. Cette autonomie est intéressante pour produire du travail de qualité, car plutôt que de limiter le jugement au respect d’une spécification, elle permet une véritable implication pratique.

Cependant avec cette opposition entre approche hacker artisanale et approche industrielle tayloriste, Hannemyr nous semble, en tout cas dans le contexte actuel de l’informatique, trancher un peu trop nettement le développement logiciel. En effet, le développement du logiciel libre n’implique pas nécessairement de se passer de spécification ou de planification. Il s’agit également de pouvoir répartir les tâches entre des développeurs. De plus, des méthodes de développement incrémental et autres méthodes « agiles » d’organisation du développement logiciel créées en réaction à des modèles extrêmement planifiés issus de l’ingénierie logicielle se sont largement répandues dans l’industrie logicielle. Cette nuance étant posée, il demeure que l’opposition entre attitude industrielle et position hacker reste pertinente historiquement et politiquement dans la mesure ou l’ingénierie logicielle est une approche de l’informatique qui se développe à la fin des années soixante dans un contexte où il s’agit de rendre « manageables » des régiments de programmeurs pour répondre à une demande croissante de produits logiciels (Tedre 2014, chap. 6). En fait d’après Hannemyr, les hackers se constituent justement en tant que groupe clairement identifié dans les années 70 par leur opposition à cette approche de la programmation qui déqualifie et détruit le sens pratique de leur travail. Söderberg et Dafermos (Söderberg et Dafermos, George 2009) parlent à ce propos d’une forme de lutte ouvrière (labour struggle) dans le champ de l’informatique.

Par ailleurs, un mode de développement contributif et itératif implique également que le programmeur travaille dans le cadre d’un système prédéfini (le logiciel avec ses bibliothèques de fonctions et ses différents modules) voire d’un système qu’il n’a pas conçu et ne maîtrise pas complètement s’il s’agit d’un contributeur ponctuel. En fait, étendre un logiciel consiste à composer avec sa forme actuelle qui impose de nombreuses contraintes : un langage de programmation particulier, un choix de cadriciel et de bibliothèques de fonctions prédéfinies, mais surtout une architecture qui définit les principales masses du logiciel et des points de passages obligés lors de la programmation. Par exemple, ajouter une nouvelle fonctionnalité à un logiciel qui organise ses données d’une certaine façon et les stocke dans une base de données spécifique va imposer au programmeur de respecter cette organisation (on parle de modèle de données) et un ensemble de façons d’accéder aux données. Ce type de contraintes peuvent parfois rendre difficile, voire presque impossible, l’ajout de fonctionnalités originales à un logiciel. Cette affirmation est d’autant plus vraie lorsque celui-ci possède une forte intégration entre ses composants et ne prévoit pas dans son architecture la possibilité d’être étendu.

Dans un tel contexte de contrainte (plus ou moins forte), une dose d’astuce et d’ingéniosité est souvent nécessaire pour toute création technique : lorsque les choix de conception d’un composant ne sont pas suffisamment versatiles (souvent pour de bonnes raisons, par exemple pour optimiser la rapidité d’exécution du programme) et qu’il n’est pas possible d’intégrer simplement ce composant d’une autre manière que celle prévue par les concepteurs, le travail de développement s’éloigne d’un simple travail de production : il est alors tout particulièrement nécessaire de comprendre les conditions de fonctionnement des composants (au niveau de leurs opérations élémentaires) et de construire par exemple une nouvelle interface entre eux pour créer les conditions nécessaires à l’extension du logiciel.

En fait, la tâche d’étendre un système, dès lors qu’il s’agit d’utiliser un code existant, un ensemble de composants définis, pour faire plus que ce que l’auteur original avait envisagé, constitue toujours d’une certaine façon une forme de transgression à l’égard de ce qu’on pourrait appeler à la suite de Madeleine Akrich le « script » du logiciel, c’est-à-dire son scénario fonctionnel (et ici fonctionnant également)53. Comme le résume Gabriella Coleman, le travail contributif de programmation rejoint alors directement la notion de hacking, dans le sens classique d’une façon de retourner un système contre lui-même54.

Cependant, cette approche de certains enjeux pratiques de la programmation, en particulier itérative n’est pas ici spécifique. Il ne s’agit pas d’affirmer qu’il existerait une façon « hacker » de programmer qui se retrouverait uniquement dans certains milieux, mais plutôt qu’une certaine dose d’attitude « hacker » fait partie intégrante de toute activité de développement logiciel et que c’est cette attitude pratique, que certains préfèreront nommer bidouille, qui est mise en avant dans le mode contributif du logiciel libre. Comme l’affirme poétiquement Julian Dibbel55, la nature de l’informatique consiste en une « collusion répétée sans fin entre liberté et déterminisme ». Le savoir-faire informatique valorisé par la culture hacker consiste en cette capacité à transcender les contraintes de la programmation par des astuces techniques afin de pouvoir jouir d’une liberté de création informatique56.

Tous les systèmes logiciels sont loin d’être également contraignants et modifiables. On désigne généralement la facilité de modification d’un logiciel, par le terme anglais de « hackability »57. Un logiciel (propriétaire) sous forme compilée dont le code source n’est pas publiquement accessible sera en pratique très difficilement hackable58. Mais même quand on dispose du code source d’un logiciel, il est parfois très difficile d’intervenir sur lui, notamment s’il est trop complexe, peu documenté et commenté, ou si comme nous l’avons évoqué, son architecture impose trop de contraintes pour développer des fonctionnalités originales. Ainsi la hackabilité dépend souvent de la coopération des concepteurs à cette pratique en un sens transgressive qu’est l’extension non sollicitée du logiciel. De nombreux logiciels libres sont volontairement conservés très simples pour être facilement maîtrisables techniquement59. D’autres, plus complexes, sont activement rendus extensibles grâce à des scripts aisément programmables60.

Insister ainsi sur cette notion de hackabilité et celle de public récursif pour décrire le phénomène du logiciel libre, montre notamment qu’avoir accès au code source n’est qu’une condition nécessaire, mais non suffisante, à la forme d’émancipation technicienne que ce mouvement porte. Ainsi en un sens fondamental, l’ouverture d’un système ne consiste pas seulement en la disponibilité du code, mais plus profondément dans la possibilité d’avoir effectivement une action transformatrice sur les logiciels et les médiations techniques qu’ils opèrent. Inversement, si l’on aborde la fermeture d’un logiciel comme l’impossibilité pratique d’influer sur les conditions de son usage et ses impacts collectifs, on constate que les enjeux de cette dernière dépassent l’impossibilité d’avoir accès au code.

Prenons, l’exemple, d’un groupe de hackers qui effectue l’ingénierie inverse d’une console de jeu vidéo61. Il sera à même d’influer radicalement sur son usage alors que cette machine répondait pleinement à la définition d’un système informatique propriétaire, voire extrêmement fermé. En effet, les industriels ajoutent généralement de nombreux mécanismes pour garantir que leurs machines ne seront pas détournées par des hackers. Ainsi, même des systèmes propriétaires peuvent être, dans une certaine mesure, l’objet d’une appropriation et d’une redéfinition de leur fonctionnement.

D’autre part, un usager pourra malgré tout se sentir impuissant face à un logiciel libre, notamment lorsqu’il n’a aucune compréhension du traitement effectué par le logiciel. Dès lors qu’il n’instaure pas un rapport pratique avec le code et le fonctionnement du logiciel, parce qu’il ne dispose pas des connaissances, n’a pas conscience ou envie d’exploiter cette possibilité, la disponibilité du code ne changera pas sa position d’usager recevant les programmes informatiques comme des objets préconçus. Ainsi, si l’usage de logiciels libres induit dans tous les cas de nombreux avantages, il fait tout particulièrement sens en lien avec une attitude particulière face aux environnements informatiques et techniques de façon plus générale. Cette attitude, que l’on pourrait qualifier d’attitude hacker, bien que cette expression soit à ce stade encore relativement floue, implique une volonté d’explorer et de transformer les conditions des infrastructures informatiques ce qui ne va pas sans poser certains problèmes dans nos sociétés.

Hacking, sécurité informatique et construction d’une figure déviante

Depuis les années 90, les activités de pénétration dans les systèmes informatiques, généralement à travers Internet, attirent l’attention médiatique et sont devenues la face la plus connue et spectaculaire du hacking62, éclipsant les autres types de pratiques63. Nous commencerons par nous intéresser techniquement à ces pratiques de pénétration.

De plus à l’époque, ces activités inédites sont rapidement considérées comme illégales et lourdement punies64. On les associe à des figures de hackers délinquants dont certains sont devenus célèbres, provoquant souvent une certaine fascination. L’une des personnalités marquantes de cette période et l’une des plus intéressantes politiquement est Kevin Mitnick. Enfermé pour ses délits informatiques pendant une durée exemplaire, il revendique son identité de hacker et a participé à rassembler politiquement la communauté du « computer underground ». Pourtant au sein d’autres groupes de la culture hacker, cette identité lui est déniée, notamment en invoquant des raisons éthiques.

Il s’agira alors d’aborder ce conflit, traduit dans l’opposition hacker légitime et cracker comme un processus de construction de déviance, dont la signification politique dépasse le cadre de la culture hacker. Le champ de la sécurité informatique peut alors apparaître sous un jour plus complexe et politique, ce qui permet en particulier de mieux comprendre la teneur de congrès hackers tels que l’historique Chaos Communication Congress65.

Pénétration informatique

Que recouvrent techniquement les pratiques de pénétration informatique (computer break in) souvent associées au hacking ? On présente* *généralement ces problématiques en introduisant une métaphore de la faille de sécurité, une sorte d’interstice dans les murs électroniques du réseau, qui serait habilement exploitée par les hackers (Jordan 2008, chap. 2). Cette métaphore, bien que pertinente à certains égards reste assez mystérieuse. Avec cette image, il est notamment difficile de comprendre pourquoi des possibilités de détournement/pénétration existent dans les systèmes, sont fréquentes, invisibles, et ne peuvent être facilement comblées a priori. Une façon plus précise d’aborder cette idée de faille est d’imaginer qu’il s’agit de faire sortir un système informatique du champ de son fonctionnement habituel en le soumettant à des cas d’interactions extrêmes et soigneusement choisies66. Généralement, ces cas non gérés se traduisent par un bogue ou arrêt brutal du système (crash). Trouver une faille consiste dès lors à identifier l’un de ces cas extrêmes qui, à cause d’un manquement dans le travail de programmation ou simplement à cause de la structure incomplète d’un système, permettent un détournement de son fonctionnement, tel que ce dernier a été défini par ses concepteurs, administrateurs et/ou propriétaires. Il existe une grande diversité67 de failles et plus largement de vecteurs de détournements/attaques68 possibles. Pour introduire plus concrètement une technique d’exploitation de faille de sécurité à travers Internet, prenons un exemple élémentaire utilisant une technique classique, l’injection SQL dans un site web.

Plus que des pages statiques écrites une fois pour toutes, les sites web actuels sont souvent en réalité des applications web c’est-à-dire des programmes complexes qui génèrent les pages web en fonction (1) des requêtes de l’utilisateur et (2) des données accumulées lors de précédentes interactions. Ces données sont stockées dans une base de données, c’est-à-dire un logiciel qui les organise de façon complexe et structurée. Pour récupérer des données dans une base, il s’agit d’écrire une requête, à la syntaxe précisément formalisée, qui définit quel sous-ensemble de toutes les données du site web il s’agit de récupérer. Ces requêtes sont généralement formulées selon le langage standard SQL. Par exemple, la requête « SELECT * FROM users WHERE name = 'bob' ; » récupère l’ensemble des informations (traduit par le symbole « * ») concernant l’utilisateur « bob » contenues dans le tableau « users » de la base de données. Lorsqu’on charge une page web, on interroge un serveur qui se charge d’écrire la page web avant de la renvoyer. Durant le processus, il s’agit notamment de chercher automatiquement (avec une requête SQL) les informations dans une base de données et de les afficher correctement sur la page.

Imaginons maintenant que cette page soit construite en fonction d’une requête personnalisée par l’utilisateur : on lui demande par exemple d’entrer son nom dans un champ et c’est la valeur de cette entrée qui sera utilisée pour récupérer les informations adéquates et les afficher sur la page. Si l’utilisateur fournit le nom « bob » et son mot de passe, les informations correspondantes seront récupérées. Mais imaginons qu’il entre à la place de son nom la phrase suivante « ' OR '1'='1' -- ». Si aucune mesure de sécurité particulière n’a été prise69, le programme chargé de construire la page remplacera le nom bob dans l’exemple de requête précédente par ce morceau écrit en langage SQL. Il en résultera la requête suivante : « SELECT * FROM users WHERE name = '' OR '1'='1' -- ; » qui a une signification en pratique bien différente : cette requête exécutée automatiquement renvoie non pas les informations de l’utilisateur Bob, mais l’ensemble des informations de tous les utilisateurs du site web. Dans un tel contexte, il est donc possible avec une simple manipulation informée, de récupérer des informations auxquelles il n’aurait pas été possible d’accéder de façon légitime en utilisant le comportement habituel du site web.

Plusieurs points sont dès lors intéressants à souligner. D’abord, l’ampleur et les conséquences d’une fuite de données peuvent être extrêmement variables. Il peut s’agir de récupérer les noms d’utilisateurs d’un site particulier pour pouvoir ensuite les cibler avec de la publicité (Jordan 2008, chap. 2), ou de voler des informations critiques (mots de passe et des numéros de carte bancaire). L’ampleur croissante des services fonctionnant grâce à des systèmes informatiques et donc de notre dépendance aux données numériques qui supporte ces services, implique qu’une fuite de données a de plus en plus de chance d’avoir un impact conséquent dans la vie réelle des personnes.

L’injection SQL est une des techniques d’exploitation les plus utilisées de la dernière décennie70. Sa force réside dans sa simplicité de mise en œuvre et les possibilités d’automatisation qu’elle implique : pour l’utiliser, il suffit de tester quelques entrées SQL dans les formulaires ou L’URL des pages d’un site web. De plus, il est possible de développer simplement des outils pour parcourir l’ensemble des pages d’un site web et tester automatiquement si des injections de code SQL sont envisageables voire d’automatiser la recherche de sites vulnérables avec un moteur de recherche comme Google.

D’autre part dans le cas de l’injection SQL comme pour la plupart des techniques basées sur l’injection71, la défaillance qui permet de lancer l’exploitation à un manque de contrôle sur les entrées utilisateurs. L’injection SQL, si elle est facile à mettre en œuvre72 est également aisée à prévenir, soit en utilisant des requêtes préparées qui suppriment le lien direct entre l’entrée-utilisateur et la base de données soit en filtrant simplement ces entrées-utilisateur pour identifier et supprimer les morceaux de code SQL. Ces procédures sont désormais incluses dans tous les cadriciels permettant de développer des sites web. Pourtant ce type de vulnérabilité continue de poser des problèmes aujourd’hui. Pour Mustafa Al-Bassam, hacker du groupe LulzSec et chercheur en sécurité informatique, la persistance de ces failles est due au manque de formation de nombreux développeurs, en particulier concernant les problématiques de sécurité ainsi qu’à la pression mise sur ces développeurs dans leur contexte de travail qui les poussent à privilégier la quantité de fonctionnalités sur la sécurité73.

Plus largement en sécurité informatique, étant donné la complexité des systèmes informatiques et les conditions imprévisibles dans lesquels ils sont déployés, les cas extrêmes non anticipés, qui peuvent constituer des vulnérabilités, sont très difficiles à anticiper et à tester. En fait, comme le rappelle par exemple Paul Taylor, les systèmes informatiques actuels apparaissent comme intrinsèquement non sécurisés74 dès lors qu’il s’agit de composer avec l’ingéniosité d’agents, qu’on qualifie habituellement d’attaquants. Étant donnée la diversité des environnements informatiques c’est-à-dire l’ampleur des configurations et interactions possibles entre les composants, il semble en effet difficile d’imaginer les anticiper a priori de façon exhaustive. Pour garantir, un fonctionnement sans imprévu, il s’agit donc de traquer et de supprimer les possibilités de détournement/pénétration au plus près des configurations concrètes une fois les systèmes déployés.

Le hacker représente ainsi une telle figure capable techniquement et de par son état d’esprit, de rassembler l’ingéniosité nécessaire pour trouver et exploiter des failles. Le mot « hacker » demeure souvent le terme générique pour désigner l’ennemi dans la littérature de sécurité informatique. Pourtant, les hackers ne sont en réalité que rarement délinquants et intéressés financièrement(Taylor 1999, 20). Leurs motivations sont avant tout le défi technique ainsi que la provocation des institutions et ce que Taylor identifie comme le « kick » : une forme d’excitation face aux difficultés et le sentiment de contrôle et de puissance induit par un hack réussi.

De plus, ce qui constitue un hack n’est pas la pénétration ou la fraude numérique en tant que telle, mais bien l’étude et le déploiement de connaissances techniques, de maîtrise pratique et d’ingéniosité par lesquels il est possible de défier les systèmes techniques établis et les organisations qui les contrôlent. À ce titre, on peut distinguer quatre types de façons d’aborder ces activités de pénétration/détournement : les attaques de type script kidding, les attaques zero-day, les attaques zero-plus-one-day et les techniques dites d’ingénierie sociale.